Dieses Open Source Tool spart mir Tausende von Euros

Jonas Scholz

Jonas ScholzFrüher habe ich 30 Dollar pro Monat (pro Nutzer!) für ChatGPT bezahlt. Dann habe ich gemerkt, dass ich das UI selbst hosten kann und Tausende sparen könnte 🤑

Ich habe alles durch ein selbst gehostetes Setup mit Open WebUI ersetzt, und es spart mir jetzt Tausende von Euros pro Jahr bei sliplane.io und Nebenprojekten.

Was ist Open WebUI?

Es ist eine Open Source, offline-first Interface für lokale und remote LLMs. Du kannst es verbinden mit:

- Ollama für lokale Models wie LLaMA, Mistral oder Phi-3

- OpenAI-kompatible APIs wie Mistral, Together, Groq, LM Studio oder LocalAI (und natürlich OpenAI selbst)

- Eingebauter RAG Support mit lokalen Dateien oder Vector Databases

- Ein modernes Interface, das sich sehr nah an ChatGPT anfühlt

Du bekommst das Meiste von ChatGPT ohne die wiederkehrenden Kosten und mit (fast) voller Kontrolle.

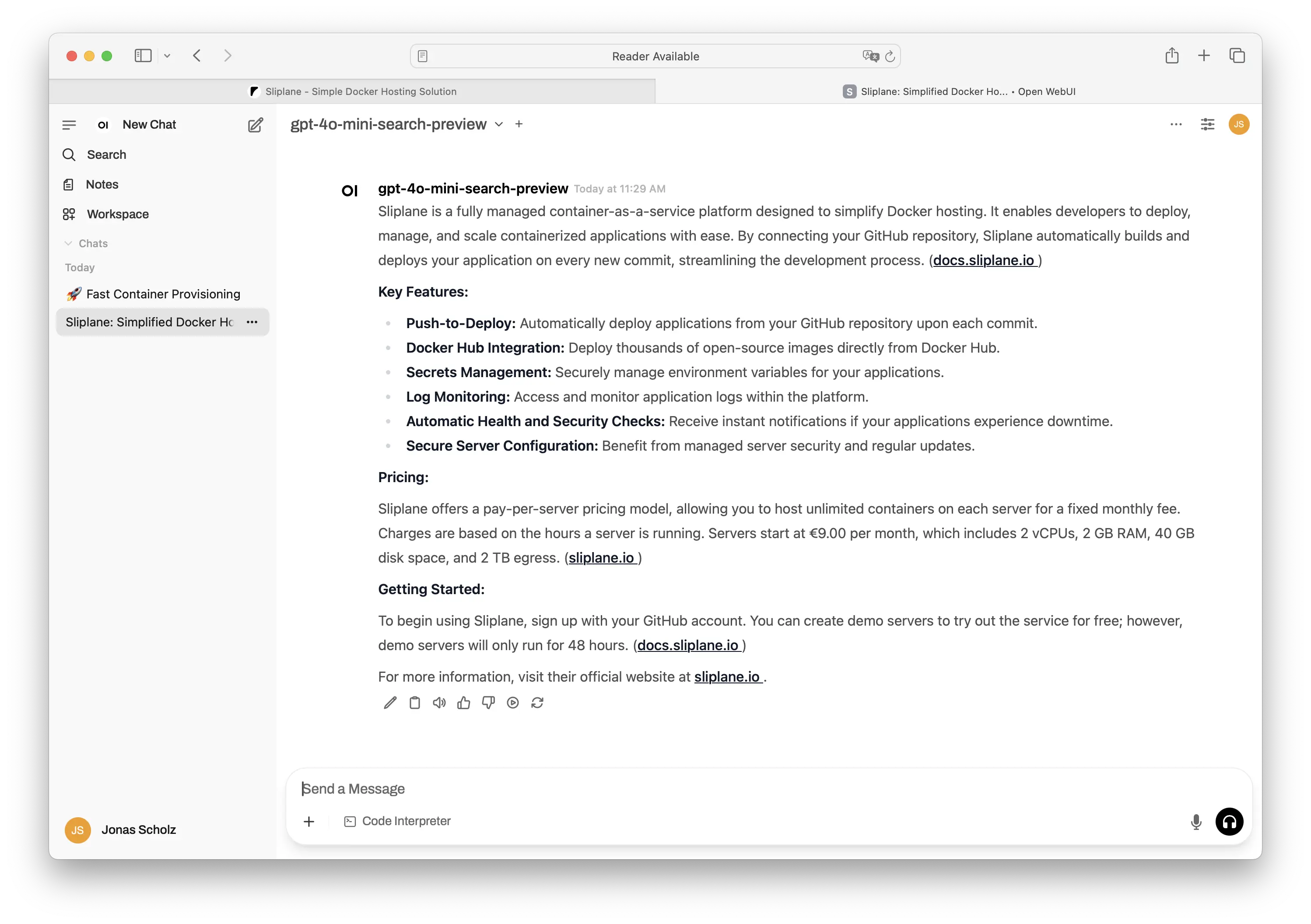

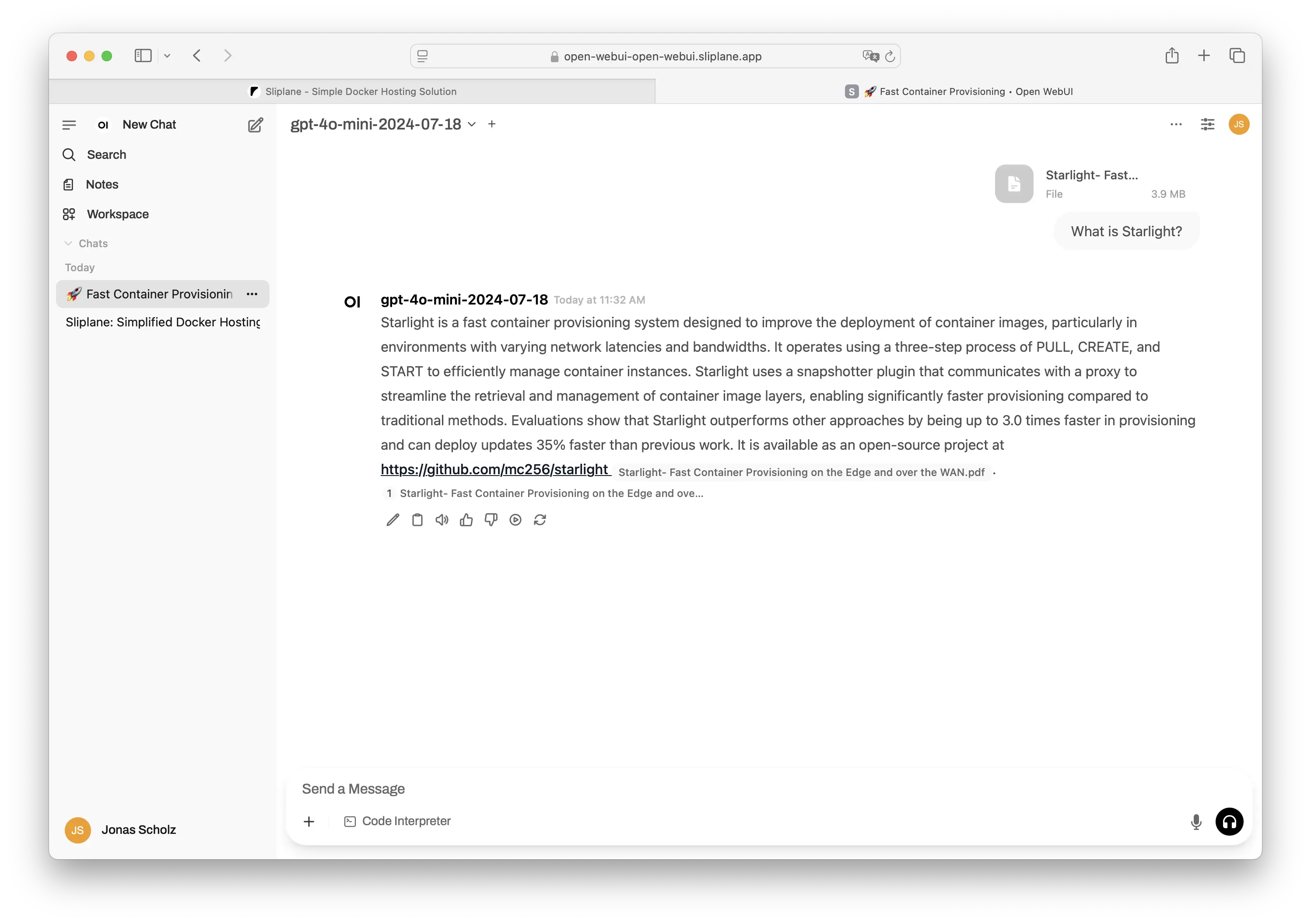

So sieht Open WebUI in Aktion aus:

Das saubere und vertraute Chat Interface

Das saubere und vertraute Chat Interface

Einfache Mitgliederverwaltung und Einstellungen

Einfache Mitgliederverwaltung und Einstellungen

Eingebauter RAG (Retrieval Augmented Generation) Support

Eingebauter RAG (Retrieval Augmented Generation) Support

Warum ich gewechselt bin

Ich habe früher für den ChatGPT Team Plan bezahlt. Dreißig Dollar pro Nutzer pro Monat. Das summiert sich schnell, wenn du ein Business oder auch nur ein kleines Team führst.

Die Wahrheit ist, wir brauchten die meisten Team Features gar nicht. Wir wollten nur ein sauberes Interface, Conversation History und zuverlässigen Model Zugang. Open WebUI hat uns genau das gegeben, und zwar kostenlos.

Mein Setup

- Open WebUI gehostet auf Sliplane

- OpenAI API Key für remote Models (oder lokal mit Ollama)

Es läuft in meiner bestehenden Infrastruktur, fühlt sich fast genauso gut an und gibt mir mehr Flexibilität. Du kannst es natürlich auf jedem Server laufen lassen, den du willst. Ich bin natürlich etwas voreingenommen und werde immer Sliplane verwenden :)

Mit Docker starten

Wenn du gerade anfängst, kannst du es mit einem einzigen Befehl starten:

docker run -d -p 3003:8080 \

-e OPENAI_API_KEY=your_secret_key \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Oder verwende Docker Compose:

services:

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

ports:

- "3000:8080"

environment:

- OPENAI_API_KEY=your_secret_key

volumes:

- open-webui:/app/backend/data

restart: always

volumes:

open-webui:

Dann öffne http://localhost:3000 in deinem Browser.

Kompromisse

Open WebUI kommt überraschend nah an die ChatGPT Features heran, aber es gibt noch einige Kompromisse:

- Du verwaltest das Backend Du wählst das Model (OpenAI, Mistral, Ollama, etc.), was bedeutet, dass du auch Latency, Verfügbarkeit und Kosten verwaltest. Große Flexibilität, aber mehr Verantwortung.

- Nicht alles ist so nahtlos Obwohl es Browsing und einen Code Interpreter hat, sind sie nicht immer so eng integriert oder poliert wie in ChatGPT. Manche Tools brauchen extra Setup (wie Dateisystem Zugang oder externe APIs).

- Self-Hosting bringt Overhead mit sich Du musst Updates, API Keys und gelegentliches Debugging verwalten. Es ist low maintenance, wenn es einmal läuft, aber trotzdem etwas zu überwachen.

- Team Features sind basic Es unterstützt mehrere Nutzer und Conversations, aber es fehlen fortgeschrittenere Enterprise Features wie rollenbasierter Zugang, Usage Analytics oder granulare Abrechnung (bin nicht super tief in dem Enterprise Zeug drin, aber ich bin sicher, es ist nicht so fortgeschritten wie ChatGPT).

Wenn du okay bist mit etwas Basteln, gibt dir Open WebUI eine riesige Menge an Wert und Kontrolle zurück.

Auf Sliplane deployen

Willst du den schnellsten Weg, um anzufangen, ohne einen Server anzufassen?

Du kannst Open WebUI auf Sliplane in unter 2 Minuten deployen:

- One Click Deploy

- HTTPS out of the box

- Secrets Management eingebaut

- Backups inklusive

- Läuft auf europäischer Infrastruktur

Die Ersparnis

So sah der Kostenunterschied für mich aus:

| Tool | Monatliche Kosten pro Nutzer | Nutzer | Jährliche Kosten |

|---|---|---|---|

| ChatGPT Team | 30 | 3 | 1080 |

| Open WebUI | 3-5 | unlimited | 108 |

| API | pay per use | geteilt | ca. 240 |

Die Kosten für Open WebUI hängen vom Hosting ab, das du verwendest. Ich habe es auf einen Base Sliplane Server gestellt, der 9 Euro pro Monat kostet. Angenommen, du hast kein Team von 100 Nutzern, die es alle gleichzeitig verwenden, wird das mehr als genug Performance sein.

Du zahlst dann auch für die API Calls, was vom Model abhängt, das du verwendest, und der Anzahl der Requests, die du machst. Aber ich kann dir garantieren, dass die meisten Nutzer nie 30 Dollar pro Monat an Usage erreichen werden :)

Abschließende Gedanken

Wenn du

- Zu viel für AI Tools ausgibst

- Dich wohl dabei fühlst, Docker zu verwenden

- Okay bist mit ein paar rauen Kanten

Dann ist das Self-Hosting von Open WebUI einer der einfachsten Wins da draußen. Kombiniere es mit einem guten API Backend wie Mistral oder lasse Models lokal mit Ollama laufen, und du bekommst das Meiste von dem, was ChatGPT bietet, für einen Bruchteil der Kosten.

Es hat mir Tausende gespart. Vielleicht macht es dasselbe für dich.

Cheers,

Jonas, Co-Founder von Sliplane